Capitalismo della Sorveglianza: Sei il Prodotto degli Algoritmi”

Parte 3 di 5: Il Capitalismo della Sorveglianza

Contents

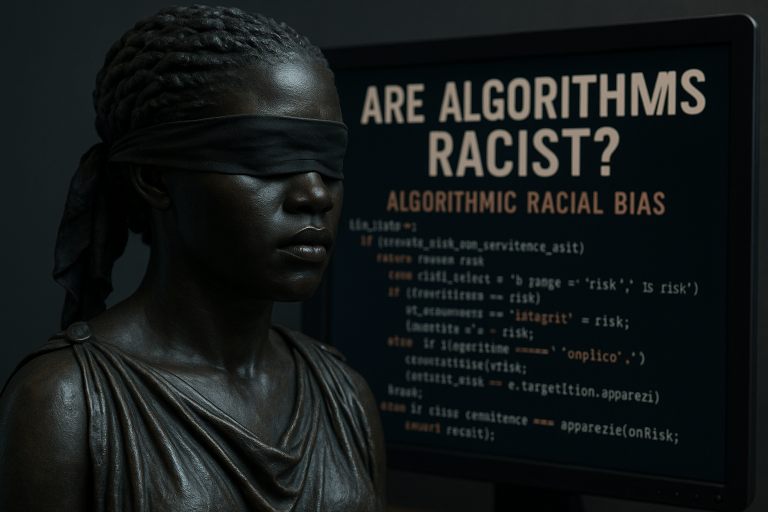

[Questa è la terza parte della serie sull’algoritmocrazia. Abbiamo esplorato, nel primo articolo, il significato di ciò che rappresentano gli algoritmi per noi. Abbiamo, poi, con il secondo articolo, scoperto come gli algoritmi possono essere discriminanti. Con oggi invece, scopriamo come non siamo noi a scegliere I prodotti ma sono loro che scelgono noi.]

Per comprendere a pieno questo processo non possiamo non tenere conto di quanto la scrittrice Shoshana Zuboff, nel suo monumentale The Age of Surveillance Capitalism, scritto nel 2019 per PublicAffairs a New York, ha spiegato. Intanto, è stato coniato il termine “capitalismo della sorveglianza“. Secondo lei, le big tech non vendono prodotti: vendono predizioni sul nostro comportamento futuro. Siamo diventati la materia prima di un’economia che estrae valore dai nostri dati. Praticamente siamo noi il prodotto, non quello che compriamo.

È una rivoluzione silenziosa, tipo. Gli algoritmi imparano dalle nostre preferenze, compreso e soprattutto Google, il quale non si limita a mostrare I risultati in una mercificazione di contenuti atti a bombardare, mi verrebbe da dire subliminale, noi ignari navigatori che miracolosamente assistiamo impassibili e senza poter fare niente a pubblicità mirate. Google impara dalle tue ricerche per costruire un profilo sempre più preciso di chi sei. E poi vende queste informazioni a chiunque sia disposto a pagare per influenzare le tue scelte. Boh, a me fa un po’ senso questa roba.

La Politica nell’Era degli Algoritmi

L’altro giorno leggevo Davide Casaleggio, nel suo recente Gli algoritmi del potere, scritto nel 2024 per Chiarelettere a Milano, e analizza come l’intelligenza artificiale stia riscrivendo le regole della politica. La sua prospettiva è interessante perché viene dal mondo politico italiano e sa di cosa parla quando si tratta di influenzare le scelte delle persone.

E ha ragione da vendere. Guardate cosa è successo nelle elezioni americane del 2016: Facebook mostrava notizie diverse a persone diverse, creando bolle informative che hanno contribuito alla polarizzazione. Due elettori della stessa città potevano vivere in realtà completamente diverse, create artificialmente da algoritmi. Pensa un po’! È come se ognuno vivesse in un mondo parallelo.

Algoritmi nell’Intimità: Anche l’Amore è Digitale

Ma non è solo politica, eh. Anche le nostre relazioni personali passano attraverso algoritmi. Tinder decide chi vedrai, Instagram sceglie quali foto dei tuoi amici mostrarti. Anche l’amore, praticamente, è mediato da sistemi informatici. Mia cugina l’altro giorno mi raccontava che ha conosciuto il fidanzato su una di quelle app, e io pensavo: ma è l’algoritmo che ha deciso che erano compatibili! Strano mondo in cui viviamo.

Human in the Loop: La Proposta di Benanti

Sul sito di Paolo Benanti, paolobenanti.com, questo francescano esperto di etica tecnologica propone il concetto di “human in the loop” – che ha sviluppato nel suo libro più recente Human in the loop. Decisioni umane e intelligenze artificiali, scritto nel 2022 per Mondadori Università a Milano. L’idea è mantenere sempre l’essere umano nel processo decisionale. Sembra sensato, ma poi come si fa praticamente?

Boh, è complicato. L’UNESCO ha pubblicato linee guida per l’etica dell’intelligenza artificiale che parlano di trasparenza e controllo umano. Tutto bello sulla carta, ma la realtà è un casino. Gli algoritmi vanno troppo veloci per la burocrazia umana.

Il problema è che molti algoritmi moderni sono intrinsecamente opachi. Anche chi li ha creati non riesce sempre a spiegare perché hanno preso una certa decisione. È quello che chiamano il “problema della scatola nera“: hai un sistema che funziona benissimo ma non capisci il ragionamento. È tipo avere un consulente super-intelligente che ti dà sempre consigli giusti ma non ti spiega mai il perché. All’inizio saresti grato, ma col tempo ti sentiresti a disagio, no?

La Trasformazione del Lavoro

Prendiamo la ricerca del lavoro, tanto per dire. Una volta mandavi il CV e speravi che qualcuno lo leggesse. Oggi il tuo curriculum viene prima analizzato da un algoritmo che cerca parole chiave, valuta il layout, analizza lo stile di scrittura. Se non passi questo filtro, nessun essere umano lo vedrà mai. Significa che devi imparare a scrivere il CV non per convincere una persona, ma per ingannare un algoritmo. È un cambiamento fondamentale nel modo in cui ci presentiamo al mondo, cioè. Come spiega la Treccani, questa trasformazione digitale sta ridefinendo il concetto stesso di lavoro.

Al lavoro c’è uno che fa recruiting e mi raccontava che ormai deve mettere certe parole chiave nei CV altrimenti il sistema li scarta automaticamente. È assurdo! Praticamente è diventato più importante sapere come parlare agli algoritmi che sapere fare il proprio lavoro. Mah.

Gli algoritmi stanno entrando anche in settori delicatissimi. Negli ospedali aiutano a diagnosticare malattie analizzando radiografie. Spesso sono più precisi dei medici, il che è fantastico. Ma quando sbagliano? Chi è responsabile? E come fai a fidarti di una diagnosi che non capisci? Mio zio lavora in ospedale e dice che i giovani medici a volte si fidano troppo dei computer. “Prima guardavamo il paziente”, dice, “ora guardiamo lo schermo”.

Scuola e Predizioni Pericolose

Nelle scuole predicono quali studenti rischiano di abbandonare gli studi. Può essere utile per interventi tempestivi. Però creano anche profezie che si auto-avverano: se l’algoritmo predice che uno studente avrà difficoltà, gli insegnanti potrebbero inconsciamente trattarlo diversamente. È un casino, perché da una parte vuoi aiutare i ragazzi in difficoltà, dall’altra rischi di creare i problemi che stai cercando di prevenire.

Momento di verità: Se un servizio online è gratuito, non sei il cliente: sei il prodotto. Ogni like, ogni scroll, ogni secondo che passi su un’app viene monetizzato. La tua attenzione è la nuova valuta del capitalismo digitale. Per approfondire questo concetto, Britannica offre un’analisi dettagliata del fenomeno.

_______________________________________________

Nel prossimo articolo: Esploreremo i principi per un’etica algoritmica e come possiamo riprendere il controllo. Parleremo di trasparenza, responsabilità e del diritto di sapere quando un algoritmo prende decisioni sulla nostra vita. È tempo di capire come difenderci!

[Ti è piaciuto questo articolo? La consapevolezza è potere: condividilo con chi usa i social senza sapere di essere il prodotto!]